Tirer parti de grands modèles de langage pour la génération de données synthétiques tabulaires

Temps de lecture : 7 minutes

L’évolution constante de l’intelligence artificielle ouvre de nouvelles perspectives passionnantes dans le domaine du traitement du langage naturel (NLP).

Au cœur de cette révolution technologique se trouvent les Large Language Models (LLM), des modèles d’apprentissage profond capables de comprendre et de générer du texte de manière remarquablement fluide et précise. Ces LLM ont suscité un intérêt considérable et sont devenus des acteurs clés dans de nombreuses applications.

Cependant, peu de recherches ont été menées sur l’utilisation d’un tel modèle pour générer des données tabulaires synthétiques, malgré sa nature générative.

La génération de données synthétiques devient un outil indispensable pour diverses industries et domaines. Que ce soit pour des raisons de confidentialité, d’accès aux données, de coût ou de quantité limitée, la capacité à générer des données synthétiques fiables et de haute qualité peut avoir un impact significatif.

Suivez-nous pour découvrir comment les LLM peuvent devenir un atout majeur pour la génération de données tabulaires synthétiques.

Qu'est-ce qu'un LLM et comment ça marche ?

Les grands modèles linguistiques (LLM) révolutionnent notre interaction avec le langage naturel, en tant que modèles d’intelligence artificielle, souvent sous forme de transformateurs. Ils s’appuient sur des réseaux neuronaux profonds, formés avec un vaste corpus de textes d’Internet. Cette formation leur permet d’atteindre un niveau de compréhension du langage humain sans précédent. Capables d’exécuter une variété de tâches linguistiques, tels que traduire, répondre à des questions complexes ou composer des paragraphes, les LLM se montrent extrêmement polyvalents. GPT-3, avec ses 175 milliards de paramètres, illustre la puissance de ces modèles, se positionnant comme l’un des LLM les plus avancés à ce jour.

Les LLM prennent en compte le contexte d’une phrase et développent une connaissance approfondie de la syntaxe et des subtilités du langage. Ils visent à prédire la séquence de mots la plus probable suivant le contexte actuel, en utilisant des techniques statistiques avancées. Autrement dit, ils calculent la probabilité de mots et de séquences de mots dans un contexte spécifique.

Dans la génération de données synthétiques, l’avantage majeur des LLM réside dans leur aptitude à modéliser des structures de données complexes. Ils identifient des informations hiérarchiques et des interdépendances entre différents termes, mimant les modèles trouvés dans de vrais ensembles de données. Cette compétence à saisir des relations complexes augmente significativement la qualité des données synthétiques produites. Pourtant, jusqu’à maintenant, peu d’études exploitent les LLM pour la création de données tabulaires synthétiques. La question demeure : comment un modèle conçu à l’origine pour le texte peut-il créer un ensemble de données structuré réaliste avec les colonnes et les lignes appropriées ?

Voyons comment les LLM peuvent être utilisés pour générer ou non des données tabulaires synthétiques de haute qualité à partir d’un ensemble de données réel.

Modélisation de distributions de données tabulaires avec GReaT

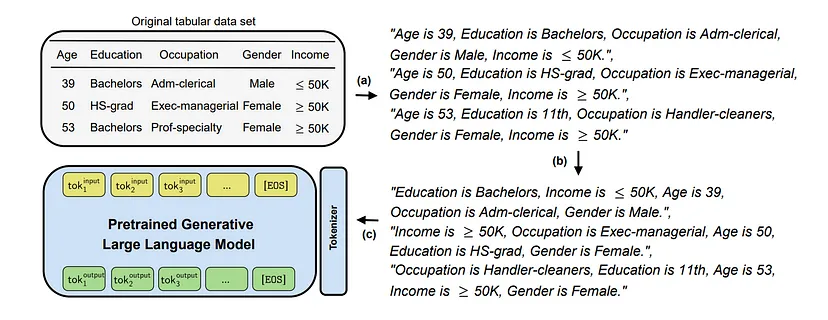

Chaque ligne de la base de données est transformée en une représentation textuelle concaténant le nom des colonnes avec leur variable à l’aide d’un opérateur de concaténation.

Comment évaluer la qualité des données synthétiques ?

Par la suite, un réglage fin est effectué sur un LLM pré-entraîné avec les données précédemment traitées. Enfin, il est possible de générer de nouvelles données synthétiques à partir des données tabulaires initiales. Pour ce faire, plusieurs options de préconditionnement sont possibles :

- Aucune valeur n’est mentionnée, le modèle génère un échantillon représentatif de la répartition des données dans l’ensemble de la base de données.

- Une paire caractéristique-variable est donnée en entrée. À partir de là, le modèle complétera l’échantillon, qui imposera à la fois une variable et guidera la génération des autres.

- Comme dans le cas précédent, il est également possible d’imposer plusieurs couples caractéristiques-variables et d’orienter encore plus la génération.

Une fois les séquences textuelles générées, une transformation inverse est effectuée afin de revenir au format tabulaire initial.

En résumé, GReaT permet d’exploiter la puissance des capacités des LLM en utilisant la compréhension du contexte pour générer des données tabulaires synthétiques de qualité, ce qui donne à cette méthode un avantage significatif par rapport aux techniques plus couramment utilisées telles que les GAN ou les VAE

Générer des ensembles de données sans données d’entraînement

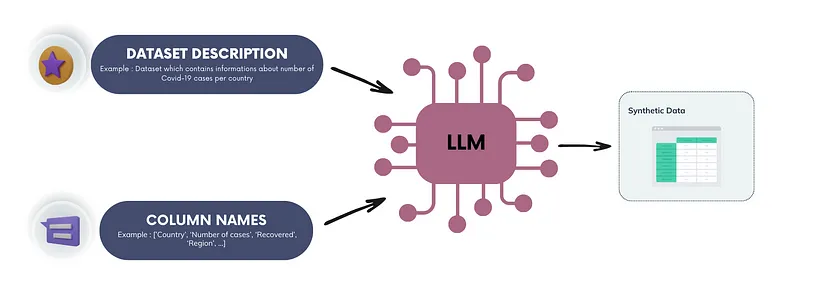

Utiliser des prompts et un LLM pour générer des données tabulaires sans base de données initiale représente une innovation en création de données synthétiques. Cette méthode convient particulièrement quand l’accès initial aux données est limité. Elle permet de produire rapidement des ensembles de données synthétiques personnalisés, offrant une alternative aux techniques comme les GAN, les VAE, ou GReaT, qui dépendent d’un ensemble de données préexistant pour l’entraînement. Cela s’avère utile, par exemple, pour tester des modèles d’intelligence artificielle sans données réelles.

Définir un prompt précis, qui spécifie le format et les caractéristiques des données tabulaires, est crucial. Il faut indiquer le nom des colonnes et le nombre de lignes souhaité. Le LLM peut alors générer un ensemble de données synthétiques avec les colonnes et le nombre de lignes spécifiés.

Le prompt doit d’abord définir le contexte de l’ensemble de données pour exploiter au mieux les compétences linguistiques du LLM. Elle doit aussi inclure les noms de colonnes et, sauf pour les premières lignes, les valeurs des lignes antérieures. Ainsi, le modèle peut enrichir l’ensemble de données en maintenant la cohérence des informations.

Créer un prompt efficace est le principal défi pour générer des données synthétiques réalistes. Souvent, il faudra affiner le prompt à travers plusieurs essais pour atteindre la précision souhaitée. On peut améliorer les résultats en fournissant des détails supplémentaires, comme une description des colonnes ou le format des variables.

Sans base de données de référence, vérifier la qualité et le réalisme des données synthétiques devient complexe. Une évaluation minutieuse par un expert devient donc essentielle pour confirmer leur validité et leur adaptabilité au contexte d’usage envisagé.

Conclusion

La rapide évolution des LLM révolutionne la génération de texte. Leur architecture complexe et leur grande capacité de compréhension contextuelle rendent possible une génération de texte sans précédent. Grâce à ces capacités, les LLM trouvent des applications dans divers domaines, y compris la génération de données synthétiques.

Pour les données tabulaires synthétiques, les LLM se montrent très prometteurs. Ils excellent à capturer des structures et des relations contextuelles complexes. Cela permet de créer des données synthétiques plus fidèles et diversifiées. La méthodologie GReaT illustre l’utilisation de données réelles pour former des modèles générant des données synthétiques de haute qualité.

L’approche basée sur les prompts, sans entraînement préalable sur données réelles, met en lumière la flexibilité des LLM. Cette méthode rapide et adaptable ouvre de nouvelles voies pour générer des données synthétiques, surtout quand les données réelles sont limitées.

L’utilisation des LLM dépasse la simple génération de textes. Leur potentiel pour atteindre d’autres objectifs, comme le développement de données synthétiques, est immense.